Un equipo combinado de roboticistas de la Universidad de Stanford y del Instituto de Investigación de Toyota ha descubierto que agregar datos de audio a los datos visuales durante el entrenamiento de robots mejora sus habilidades de aprendizaje. La investigación ha sido publicada en el servidor de preimpresiones arXiv.

Los investigadores notaron que prácticamente todo el entrenamiento de robots basados en IA se realiza exponiéndolos a una gran cantidad de información visual, ignorando el audio asociado. Por eso, se preguntaron si agregar micrófonos a los robots y permitirles recolectar datos sobre cómo algo debe sonar mientras se realiza podría ayudarles a aprender mejor una tarea.

El experimento

Para averiguarlo, diseñaron y llevaron a cabo cuatro experimentos de aprendizaje robótico. En el primero se le enseñó a un robot a voltear un bagel en una sartén usando una espátula. El segundo implicó enseñar a un robot a usar un borrador para borrar una imagen en una pizarra blanca.

El tercero consistió en verter dados de un vaso a otro, y el cuarto experimento los llevó a elegir el tamaño correcto de cinta adhesiva entre tres muestras disponibles y usarla para pegar un cable a una tira de plástico. Para realizar los experimentos, el robot solo estaba equipado equipado con una garra y se evaluó su desempeño de dos maneras diferentes: usando solo video y usando video y audio.

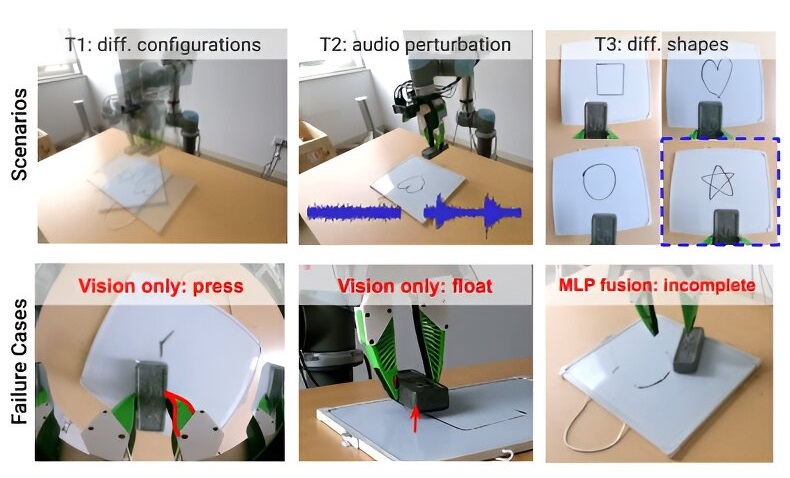

El equipo varió factores de enseñanza y rendimiento, como la altura de la mesa, el tipo de cinta o el tipo de imagen en la pizarra blanca. Finalmente, los investigadores compararon los resultados evaluando la rapidez y facilidad con la que los robots pudieron aprender y llevar a cabo las tareas, así como su precisión.

Los resultados

Encontraron que agregar audio mejoró significativamente la velocidad y precisión en algunas tareas, pero no en otras. Por ejemplo, agregar audio a la tarea de verter dados mejoró drásticamente la capacidad del robot para determinar si había dados en el vaso. También ayudó al robot a entender si estaba ejerciendo la cantidad correcta de presión sobre el borrador, debido al sonido único producido.

Sin embargo, agregar sonido no ayudó mucho a determinar si el bagel había sido volteado con éxito o si toda una imagen había sido eliminada de una pizarra blanca. El equipo concluye que agregar audio al material de enseñanza para robots de IA podría proporcionar mejores resultados para algunas aplicaciones.